Kurzfassung in 30 Sekunden

- Zielgruppe: KMU mit verstreutem Wissen in Dokumenten, Arbeitsanweisungen, E-Mails oder ERP-Reports.

- Problem: Wissen ist vorhanden, aber schwer auffindbar oder nur Einzelpersonen bekannt.

- Lösung: Retrieval-Augmented Generation (RAG) macht Wissen durch natürliche Sprache zugänglich.

- Nutzen: Schnellere Antworten, weniger Suchaufwand, keine Abhängigkeit von Einzelwissen, sicherer Datenzugriff.

Ein alltägliches Problem

In nahezu jedem Unternehmen steckt wertvolles Wissen – in E-Mails, PDFs, Protokollen oder Anweisungen. Doch wer eine konkrete Frage hat, sucht oft minutenlang. Genau hier hilft Retrieval-Augmented Generation: ein KI-Ansatz, der relevante Dokumente findet und mit Sprachmodellen verknüpft – damit Antworten direkt aus dem Unternehmenswissen entstehen.

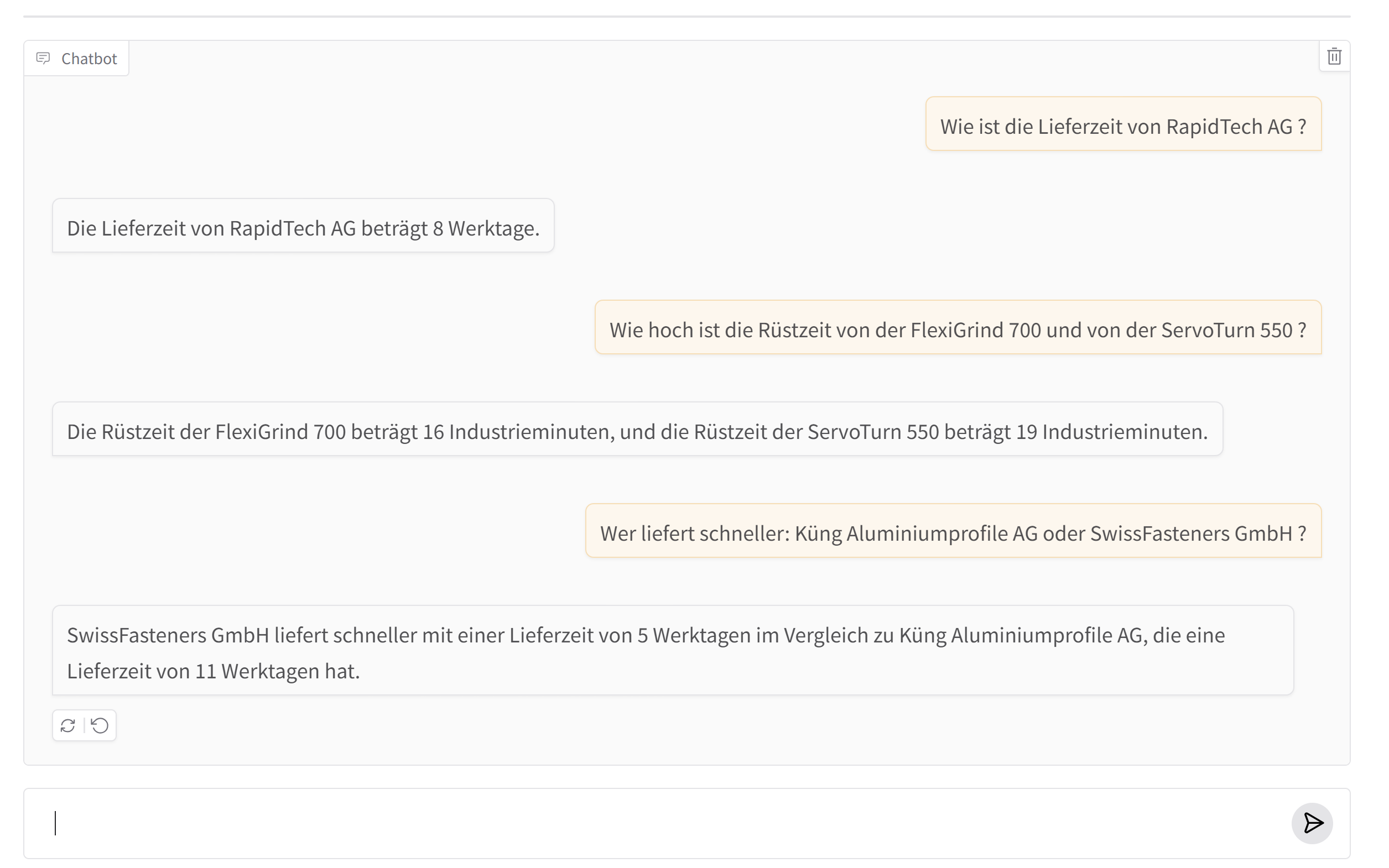

Praxisbeispiele

- Produktion: Ein Metallbaubetrieb durchsucht seine Arbeitsanweisungen direkt mit Fragen wie „Wie war die Toleranzvorgabe für Teil A-142?“ und erhält exakte Ergebnisse.

- Vertrieb: Außendienstmitarbeiter nutzen eine offline-fähige RAG-App auf dem Tablet, um Produktdaten auch ohne Internet zu finden.

- Kundendienst: Das Serviceteam beantwortet Kundenanfragen automatisch auf Basis interner FAQs und ERP-Daten.

Sicherheit & Datenschutz

- On-Premise: Betrieb im lokalen Netzwerk oder NAS, keine Cloud notwendig.

- Rollen & Rechte: Jede Wissensinsel hat klar definierte Zugriffe.

- Transparenz: Alle Antworten enthalten Quellenangaben aus Originaldokumenten.

Wie RAG funktioniert

Dateien vorbereiten

Texte, PDFs oder Berichte werden in kleine Sinnabschnitte („Chunks“) zerlegt – so kann die KI gezielt suchen.

Vektorisieren

Jeder Abschnitt wird in einen semantischen Zahlenraum umgewandelt (Vektor). So erkennt die KI Ähnlichkeiten und Bedeutungen.

Speichern & Abrufen

Die Vektoren werden in einer Datenbank wie Qdrant, Chroma, FAISS oder Weaviate gespeichert und bei Fragen abgefragt.

Antwort generieren

Nur die relevantesten Textstellen werden an das Sprachmodell (z. B. gpt-4o-mini, mistral-7b-instruct, gemma-2-9b-instruct) übergeben – es erstellt eine präzise Antwort mit Quellenangabe.

Technologie-Stack

Die wichtigsten Komponenten für modulare Wissensinseln im Überblick:

Vektordatenbanken: Qdrant, Chroma, Weaviate, FAISS – speichern semantische Repräsentationen.

Frameworks: LangChain, LlamaIndex, Haystack – orchestrieren Suche und Antwortgenerierung.

LLMs: Mistral, OpenAI, Ollama – formulieren kontextbasierte Antworten.

APIs & Tools: FastAPI, Node.js, n8n, Python Apps. – ermöglichen Integration in bestehende Workflows.

Deployment: AWS, Vercel, Azure, GCP, Docker, NAS, lokale Server – volle Datenkontrolle und einfache Wartung.

Wissensinseln statt Riesen-KI

Anstatt eine zentrale, unüberschaubare KI aufzubauen, teilen wir das Wissen in spezialisierte RAG-Module auf – sogenannte Wissensinseln. Jede Insel hat ihren eigenen Datensatz, Zugriffskreis und Zweck.

| Abteilung | RAG-Konstellation | Datenquellen | Besonderheiten |

|---|---|---|---|

| Vertrieb | Offline / leichtgewichtig (FAISS, Chroma) | Preislisten, Produktdaten | Offline nutzbar, schnelle Antworten |

| Produktion | Lokal (Qdrant) | Arbeitsanweisungen, Handbücher | Hohe Sicherheit, kein Internet nötig |

| Support | Cloud / Hybrid (Pinecone, Supabase) | FAQs, Tickets | Extern zugänglich, Chatbots möglich |

| Geschäftsleitung | Private KB (persistenter Index) | Berichte, Strategiedokumente | Vertraulich, lokal gespeichert |

Zukunftsausblick

RAG ist der logische nächste Schritt nach DMS. Künftig verbinden sich die Wissensinseln über Meta-Suche und Graph-Beziehungen (GraphRAG) zu einer flexiblen Unternehmens-KI – modular, sicher und skalierbar.

Fazit

RAG bringt künstliche Intelligenz genau dorthin, wo sie echten Mehrwert schafft – in den Alltag und in Ihre Teams. Statt eine große Blackbox zu bauen, entsteht eine transparente, modulare Wissenslandschaft. Das Motto: klein starten, gezielt wachsen.

Gern zeige ich Ihnen, wie sich Wissensinseln in Ihrem Unternehmen praktisch umsetzen lassen – lokal, kontrolliert und budgetbewusst.